数据库

药物化学

defer

ssm

最短路

flask

办公软件

QTextToSpeech

编辑器

指针数组

rknn

Setup 函数的使用

鹈鹕优化算法(POA)

泰勒展开式

批量制图

镜像源

知识计算

营销电子邮件

推荐计划

企业人事管理系统

梯度

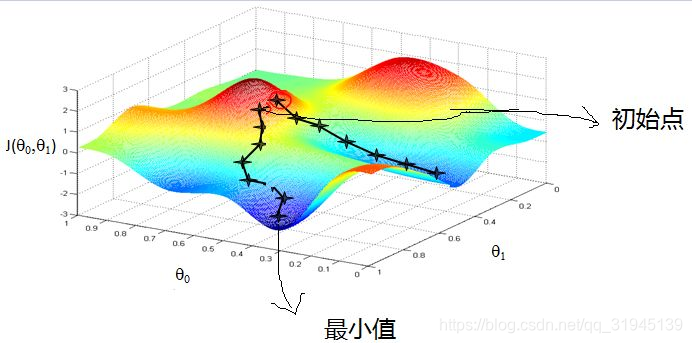

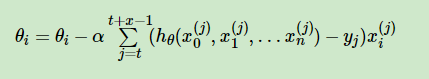

2024/4/11 23:35:38随机梯度下降法的数学基础

梯度是微积分中的基本概念,也是机器学习解优化问题经常使用的数学工具(梯度下降算法)。因此,有必要从头理解梯度的来源和意义。本文从导数开始讲起,讲述了导数、偏导数、方向导数和梯度的定义、意义和数学公式…

【Math】导数、梯度、雅可比矩阵、黑塞矩阵

导数、梯度、雅可比矩阵、黑塞矩阵都是与求导相关的一些概念,比较容易混淆,本文主要是对它们的使用场景和定义进行区分。

首先需要先明确一些函数的叫法(是否多元,以粗体和非粗体进行区分):

一元函数&…

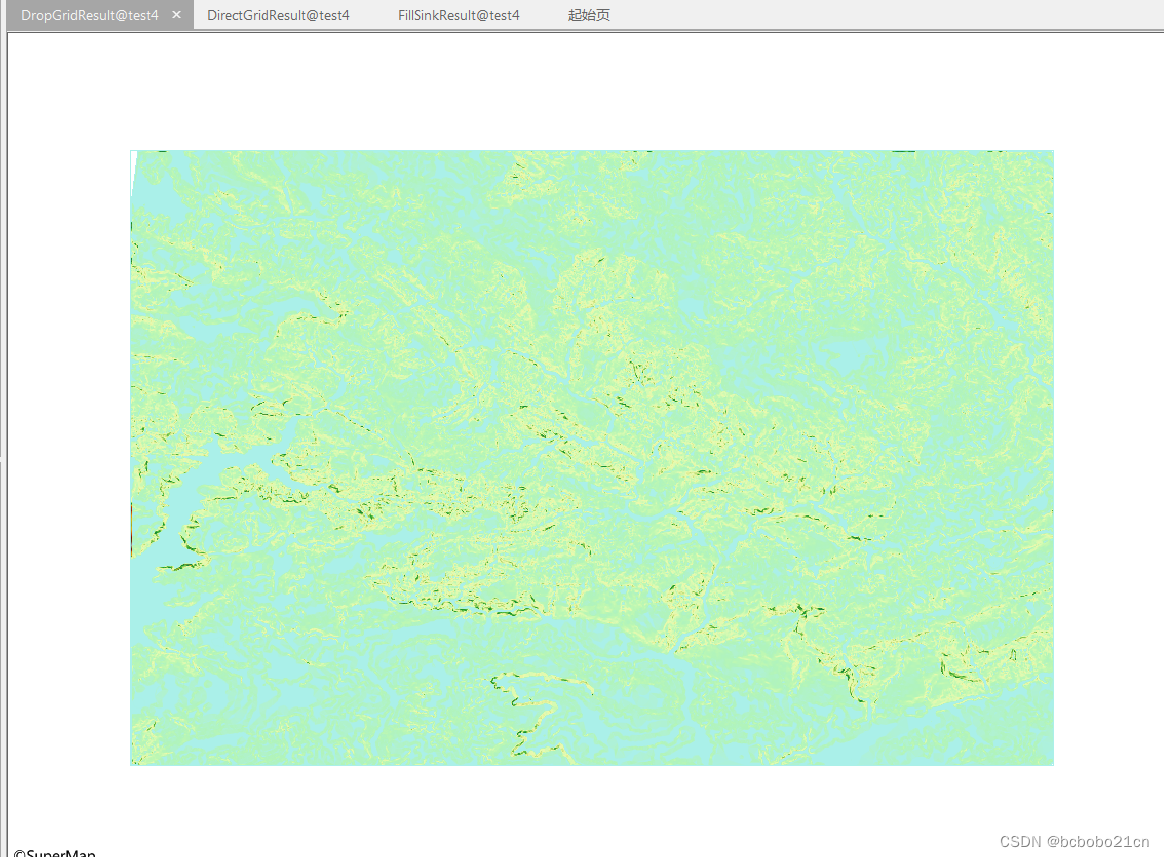

GIS水文分析计算流向学习

1 初步操作

流向,即水文表面水的流向; 水文分析的很多功能需要基于流向栅格;

在 SuperMap 中,对中心栅格的8个邻域栅格进行编码; 每一个中心栅格的水流方向都由这八个值中的某一个值来确定;

我还没弄懂水…

pytorch 0.4 改动: cannot resize variables that require grad

在pytorch0.3中做过一些关于张量求梯度的工作,目的是扩展一下pytorch的module,今天升级pytorch0.4,发现原先的代码不可用,报错如下: RuntimeError: cannot resize variables that require grad

在pytorch 0.3中&…

《Understanding Black-box Predictions via Influence Functions》笔记

[1] 通过升权( 2.1 \S 2.1 2.1)、扰动( 2.2 \S 2.2 2.2)两种方式研究某个 training point z ( x , y ) z(x,y) z(x,y) 对(优化后的)模型参数 θ ^ \hat\theta θ^、模型在某个 test point z test ( …

Pytorch中的梯度知识总结

文章目录1.叶节点、中间节点、梯度计算2.叶子张量 leaf tensor (叶子节点) (detach)2.1 为什么需要叶子节点?2.2 detach()将节点剥离成叶子节点2.3 什么样节点会是叶子节点2.3 detach(),detach_() 的作用和区别2.4 clone()与detach()的区别5.optimizer.z…

导数、偏导数、梯度之间的关系

导数

导数(Derivative),也叫导函数值。又名微商,是微积分中的重要基础概念。当函数yf(x)的自变量x在一点x0上产生一个增量Δx时,函数输出值的增量Δy与自变量增量Δx的比值在Δx趋于0时的极限a…

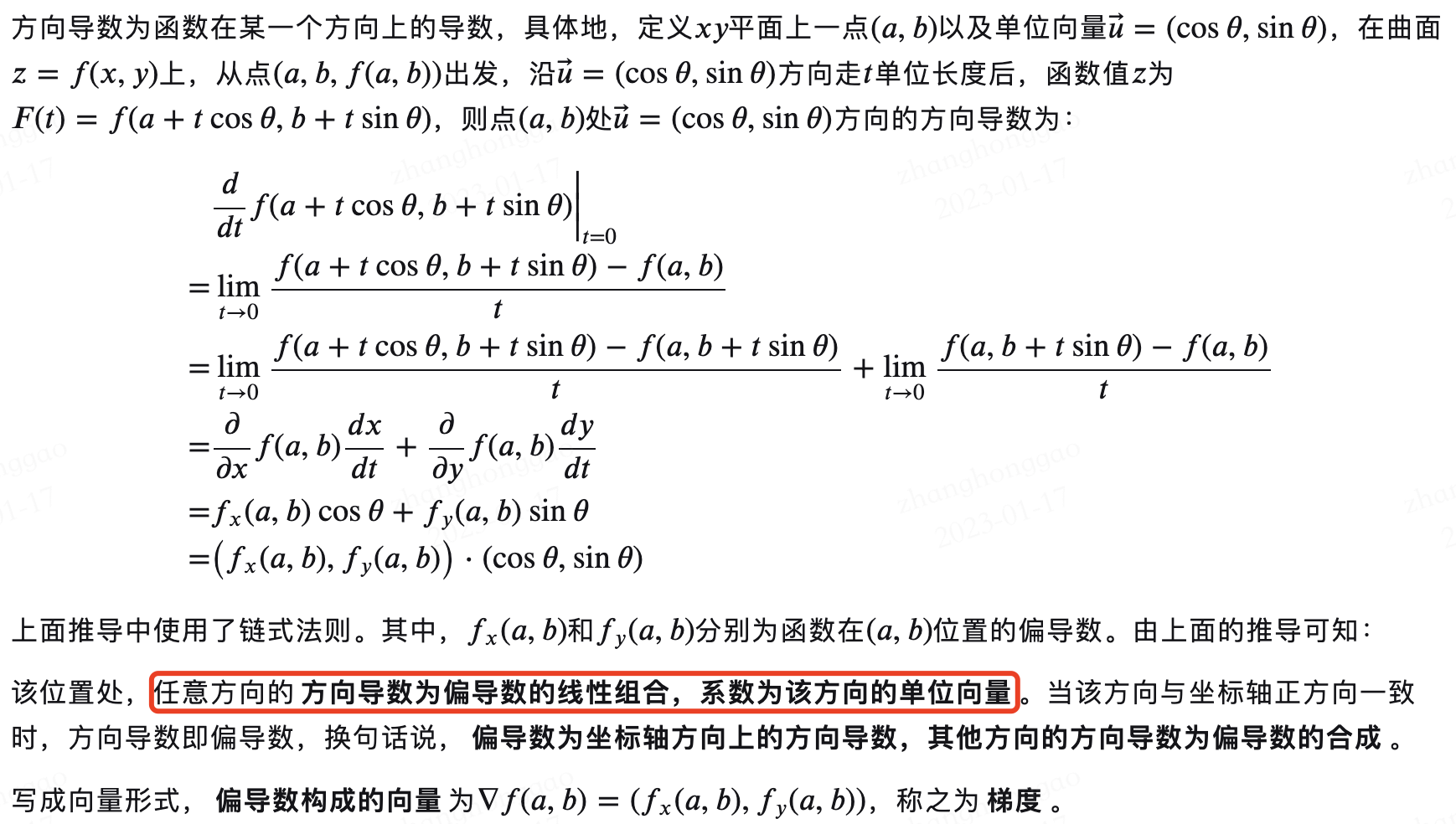

再理解偏导数、方向导数、梯度之间的关系

再理解偏导数、方向导数、梯度之间的关系

本人相关笔记: 1.偏导数(Partial Derivative) 2.方向导数和梯度向量

个人总结: 1.偏导数反映多元函数沿坐标轴的变化率 2.方向导数反映多元函数沿任一指定方向的变化率 3.梯度本质是一个向量,梯度方…

GEE机器学习——利用梯度决策树Gradient Tree Boost 方法(GBDT/GBRT)进行土地分类和精度测试

Gradient Tree Boost 方法的具体介绍

梯度提升树(Gradient Tree Boost)是一种集成学习方法,通过串行训练多个决策树来解决回归和分类问题。它通过迭代的方式不断优化模型预测结果,使得每一棵树能够纠正前一棵树的预测误差。

Gradient Tree Boost方法的具体步骤如下: 1. …